T3-Magazin / Getty Images

Akademische Forscher haben einen neuen Exploit entwickelt, der intelligente Lautsprecher von Amazon Echo verwendet und sie zwingt, Türen zu öffnen, nicht autorisierte Telefonanrufe und Einkäufe zu tätigen und Öfen, Mikrowellen und andere intelligente Geräte zu steuern.

Der Angriff funktioniert, indem der Lautsprecher des Geräts verwendet wird, um Sprachbefehle auszugeben. Forscher von Royal Holloway in London und der italienischen Universität von Catania fanden heraus, dass Echo es ausführt, solange die Sprache das Weckwort des Geräts (normalerweise „Alexa“ oder „Echo“) gefolgt von einem zulässigen Befehl enthält. Selbst wenn Geräte eine verbale Bestätigung erfordern, bevor sensible Befehle ausgeführt werden, ist es trivial, die Aktion zu umgehen, indem etwa sechs Sekunden nach Ausgabe des Befehls „Ja“ hinzugefügt wird. Angreifer könnten auch das ausnutzen, was Forscher „FVV“ oder Full Volume Vulnerability nennen, was es Echos ermöglicht, autonome Befehle auszugeben, ohne die Lautstärke des Geräts vorübergehend zu reduzieren.

Alexa, hack dich selbst

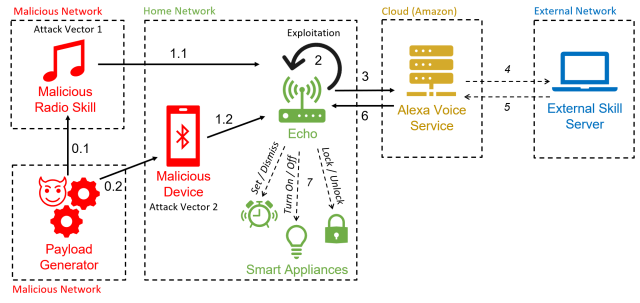

Da der Hack Alexa-Funktionalität nutzt, um Geräte dazu zu zwingen, autonome Befehle auszugeben, haben Forscher ihn „AvA“ genannt, kurz für Alexa versus Alexa. Es dauert nur wenige Sekunden, sich einem anfälligen Gerät zu nähern, während es eingeschaltet ist, damit ein Angreifer einen Sprachbefehl aussprechen kann, der es anweist, es mit dem Bluetooth-fähigen Gerät des Angreifers zu koppeln. Solange sich das Gerät in der Funkreichweite des Echos befindet, kann der Angreifer Befehle erteilen.

In der Zeitschrift Echo schrieben die Forscher, dass der Angriff „der erste seiner Art ist, der die Schwachstelle willkürlicher Selbstbefehle auf Echo-Geräten ausnutzt und es Angreifern ermöglicht, sie über einen längeren Zeitraum zu kontrollieren“. Papier Gepostet vor zwei Wochen. „Mit dieser Arbeit beseitigen wir die Notwendigkeit, einen externen Lautsprecher in der Nähe des Zielgeräts zu haben, was die Gesamtwahrscheinlichkeit eines Angriffs erhöht.“

Eine Angriffsform nutzt einen böswilligen Radiosender, um autonome Befehle zu generieren. Dieser Angriff ist nach den Sicherheitspatches, die Echoaker Amazon als Reaktion auf die Recherchen veröffentlicht hat, in der im Papier beschriebenen Weise nicht mehr möglich. Forscher haben bestätigt, dass die Angriffe gegen Echo Dot-Geräte der dritten und vierten Generation funktionieren.

Esposito und andere

AvA beginnt, wenn sich ein anfälliges Echo-Gerät über Bluetooth mit dem Gerät des Angreifers verbindet (und bei ungepatchten Echos, wenn sie den bösartigen Radiosender abspielen). Von nun an kann der Angreifer eine Text-to-Speech-Anwendung oder andere Mittel verwenden, um Sprachbefehle zu streamen. Hier ist ein Video von AvA in Aktion. Alle Angriffsformen bleiben möglich, außer was zwischen 1:40 und 2:14 erscheint:

Alexa gegen Alexa – Demo.

Forscher haben herausgefunden, dass sie AvA verwenden können, um Geräte zu zwingen, eine Reihe von Befehlen auszuführen, von denen viele schwerwiegende Folgen für die Privatsphäre oder Sicherheit haben. Mögliche schädliche Aktionen umfassen:

- Steuern Sie andere intelligente Geräte, z. B. das Ausschalten des Lichts, das Einschalten eines intelligenten Mikrowellenofens, das Einstellen der Heizung auf eine unsichere Temperatur oder das Öffnen intelligenter Türschlösser. Wie bereits erwähnt, muss der Gegner, wenn Echos eine Bestätigung verlangt, nur etwa sechs Sekunden nach der Anfrage ein „Ja“ an den Befehl anhängen.

- Rufen Sie eine beliebige Telefonnummer an, einschließlich der vom Angreifer kontrollierten, damit Geräusche in der Nähe belauscht werden können. Während Echos ein Licht verwendet, um anzuzeigen, dass sie telefonieren, sind die Geräte für Benutzer nicht immer sichtbar, und weniger erfahrene Benutzer wissen möglicherweise nicht, was das Licht bedeutet.

- Tätigen Sie nicht autorisierte Käufe mit dem Amazon-Konto des Opfers. Obwohl Amazon eine E-Mail sendet, um das Opfer über den Kauf zu informieren, kann die E-Mail übersehen werden oder der Benutzer kann das Vertrauen in Amazon verlieren. Alternativ könnten Angreifer auch bereits im Warenkorb des Kontos befindliche Artikel löschen.

- Manipulieren des zuvor verknüpften Kalenders eines Benutzers, um Ereignisse hinzuzufügen, zu verschieben, zu löschen oder zu ändern.

- Identitätswechsel-Fertigkeiten oder starten Sie eine beliebige Fertigkeit nach Wahl des Angreifers. Dies wiederum könnte es Angreifern ermöglichen, an Passwörter und persönliche Daten zu gelangen.

- Erinnern Sie sich an alle Aussagen des Opfers. Mithilfe eines sogenannten „Maskenangriffs“ kann ein Angreifer Befehle abfangen und in einer Datenbank speichern. Dies kann es dem Gegner ermöglichen, private Daten zu extrahieren, Informationen über die verwendeten Fähigkeiten zu sammeln und auf Benutzergewohnheiten zu schließen.

Die Forscher schrieben:

Durch diese Tests haben wir gezeigt, dass AvA verwendet werden kann, um zufällige Bestellungen jeder Art und Länge mit perfekten Ergebnissen zu erteilen – insbesondere kann ein Angreifer Smart Lights mit einer Erfolgsquote von 93 % steuern und erfolgreich unerwünschte Artikel bei Amazon kaufen 100% der Zeit und durcheinander [with] Zugehöriger Kalender mit 88% Erfolgsquote. Komplexe Befehle, die vollständig erkannt werden müssen, um erfolgreich zu sein, wie das Anrufen einer Telefonnummer, haben eine nahezu perfekte Erfolgsquote, in diesem Fall 73 %. Darüber hinaus zeigen die in Tabelle 7 gezeigten Ergebnisse, dass der Angreifer erfolgreich einen Audio-Maskerade-Angriff über die Maskenangriffsfertigkeit einrichten kann, ohne entdeckt zu werden, und alle gesprochenen Wörter abgerufen und in der Datenbank des Angreifers gespeichert werden können, nämlich 41 in unserem Fall .

More Stories

Neue Trends in der Technologie

Neue Warnung vor Passwort-Hacking für Gmail-, Facebook- und Amazon-Benutzer

Lamborghini Revoleto: 4-Sterne-Bewertung